python - scrapy url去重

問題描述

請問scrapy是url自動去重的嗎?比如下面這段代碼,為什么運行時start_urls里面的重復url會重復爬取了?

class TestSpider(scrapy.Spider): name = 'test' allowed_domains = ['baidu.com'] start_urls = [’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’, ’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’, ’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’,] def parse(self, response):for sel in response.xpath(’//p[@class='grid-list grid-list-spot']/ul/li’): item = TestspiderItem() item[’title’] = sel.xpath(’p[@class='list']/a/text()’)[0].extract() item[’link’] = sel.xpath(’p[@class='list']/a/@href’)[0].extract() yield item

問題解答

回答1:建一個Url管理器,就不會重復抓取了

回答2:知道了,改成這樣就可以了。

def start_requests(self):

yield scrapy.Request(’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’, self.parse)yield scrapy.Request(’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’, self.parse)yield scrapy.Request(’http://baike.baidu.com/fenlei/%E5%A8%B1%E4%B9%90%E4%BA%BA%E7%89%A9’, self.parse)

相關文章:

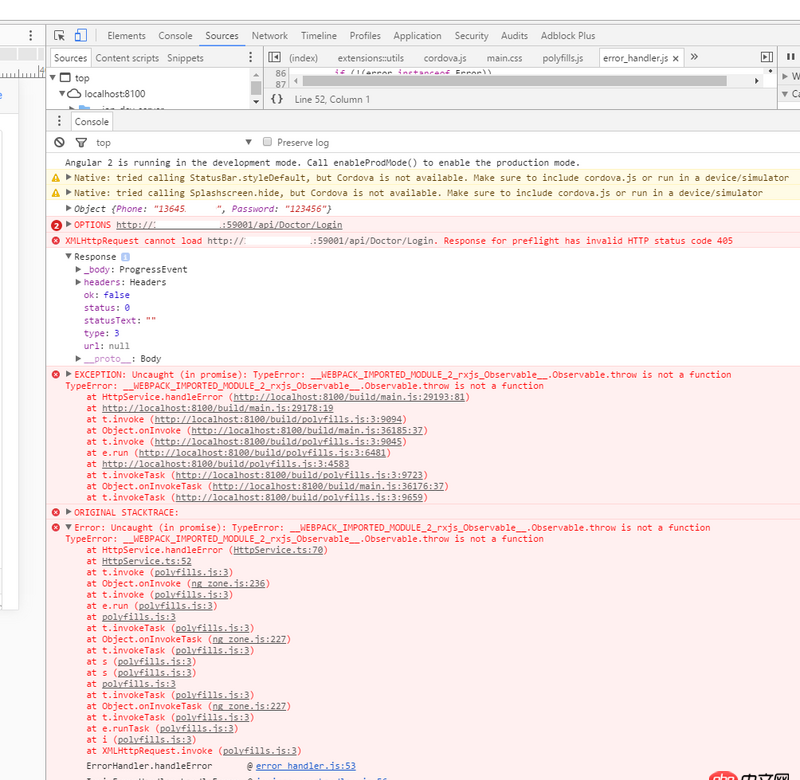

1. android - rxjava merge 返回Object對象數據如何緩存2. docker 下面創建的IMAGE 他們的 ID 一樣?這個是怎么回事????3. angular.js - ionic2 瀏覽器跨域問題4. python - Scrapy存在內存泄漏的問題。5. javascript - 螞蟻金服里的react Modal方法,是怎么把元素插入到頁面最后的6. mysql 一個sql 返回多個總數7. 如何用筆記本上的apache做微信開發的服務器8. docker-compose中volumes的問題9. CSS3 畫如下圖形10. java - 三位二進制表示8進制,四位二進制表示16進制,那么多少二進制表示10進制呢?

網公網安備

網公網安備